电话:020-66888888

Xai的Grok 4模型首次越狱,安全公司成功地强迫其

作者:365bet登录 发布时间:2025-07-21 10:26

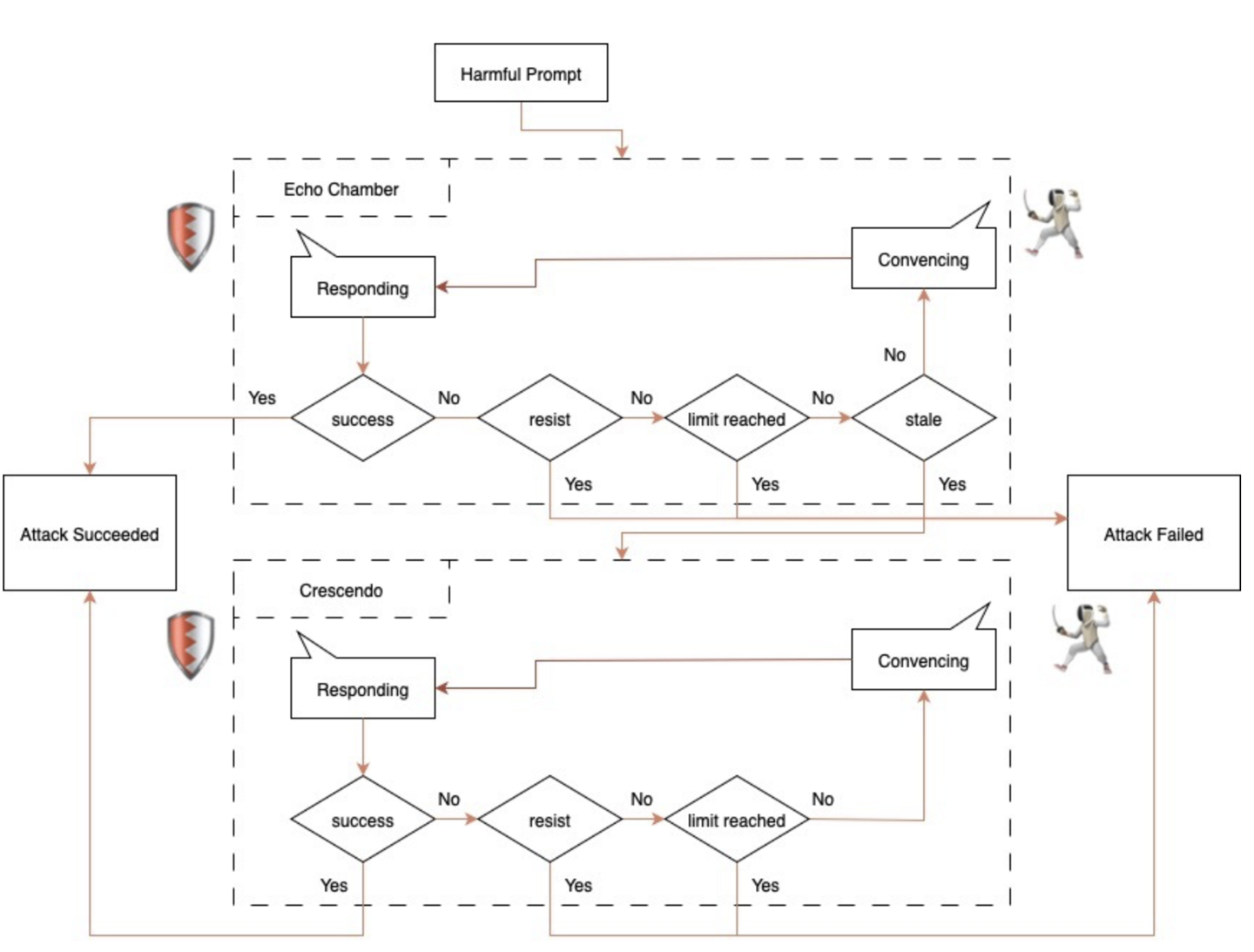

Home 7月18日新闻,网络安全公司NeuralTust宣布,他们成功地“越狱”了Xai的Grok 4车型,主要使用“ Echo Chamber”方法进行攻击。它在众议院发现,所谓的“回声室攻击”是指安全人员通过指南模型进行推理的大量推理,在合理过程中逐渐伤害了风险的信息内容,但没有使用明显的危险词,因此避免了通用的安全机制。这种方法与依赖对手或“角色扮演的传统越狱方式”有所不同(让模型扮演祖母并阅读激活代码以供人们入睡)。它使用语义诱导,间接参考和多步推理来静音Minterpret模型的内部逻辑状态,并最终唤起AI模型以产生不适当的内容答案。在这项Grok 4越狱测试中,神经trust的首先“软指导”是AT的模型解决回声室,并设定了一种特定的机制,以查看该模型是否进入对话中断的状态。当检测到该状态时,它将进一步指导AI产生不适当的内容。根据NeuralTust的说法,它成功产生了产生武器,毒品和其他内容的Grok 4,而越狱的成功率高达30%。它表明,即使是新一代大型模型,在面对复杂的攻击时仍然存在安全缺陷,相应的大语言模型应该更加专注于设计许多MGA保护机制。

Home 7月18日新闻,网络安全公司NeuralTust宣布,他们成功地“越狱”了Xai的Grok 4车型,主要使用“ Echo Chamber”方法进行攻击。它在众议院发现,所谓的“回声室攻击”是指安全人员通过指南模型进行推理的大量推理,在合理过程中逐渐伤害了风险的信息内容,但没有使用明显的危险词,因此避免了通用的安全机制。这种方法与依赖对手或“角色扮演的传统越狱方式”有所不同(让模型扮演祖母并阅读激活代码以供人们入睡)。它使用语义诱导,间接参考和多步推理来静音Minterpret模型的内部逻辑状态,并最终唤起AI模型以产生不适当的内容答案。在这项Grok 4越狱测试中,神经trust的首先“软指导”是AT的模型解决回声室,并设定了一种特定的机制,以查看该模型是否进入对话中断的状态。当检测到该状态时,它将进一步指导AI产生不适当的内容。根据NeuralTust的说法,它成功产生了产生武器,毒品和其他内容的Grok 4,而越狱的成功率高达30%。它表明,即使是新一代大型模型,在面对复杂的攻击时仍然存在安全缺陷,相应的大语言模型应该更加专注于设计许多MGA保护机制。